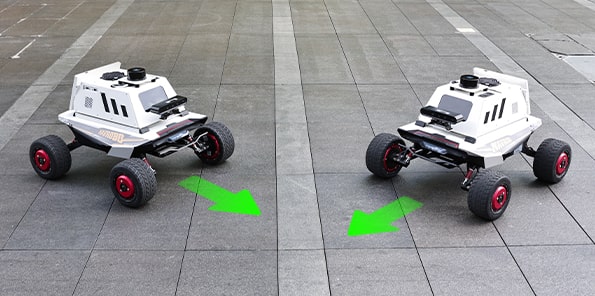

大尺寸四驱底盘,独立悬挂可让机器人适应复杂环境,具有很强的通过性和地面适应性。

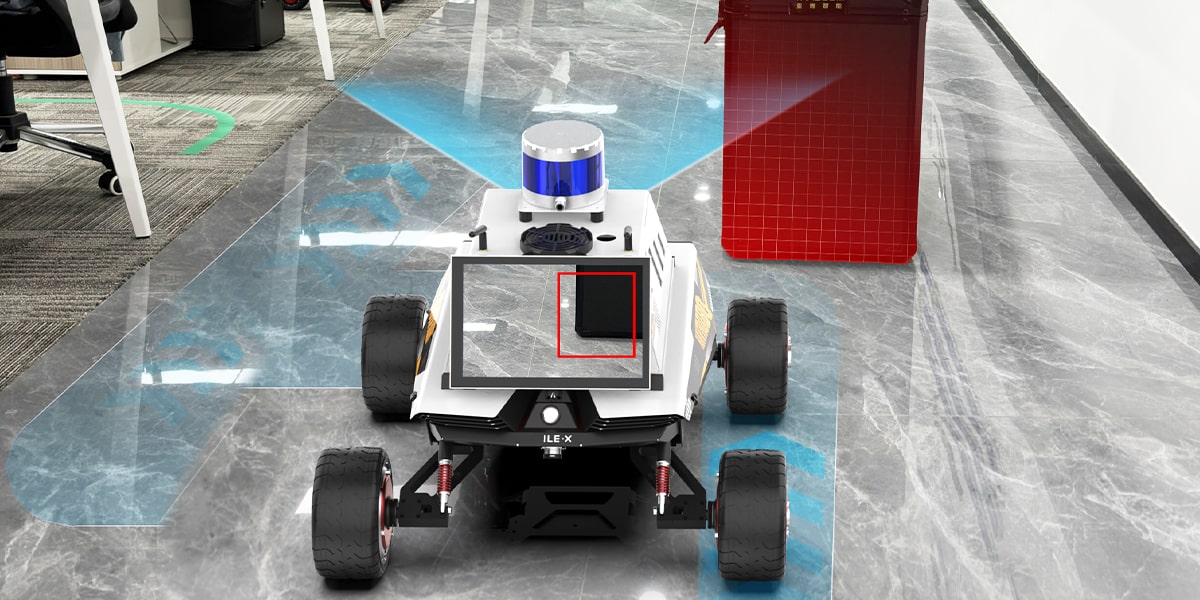

双目结构光深度相机可应用于室内外场景,可应对室外环境光影响,专为机器人导航和视觉识别等应用而生。

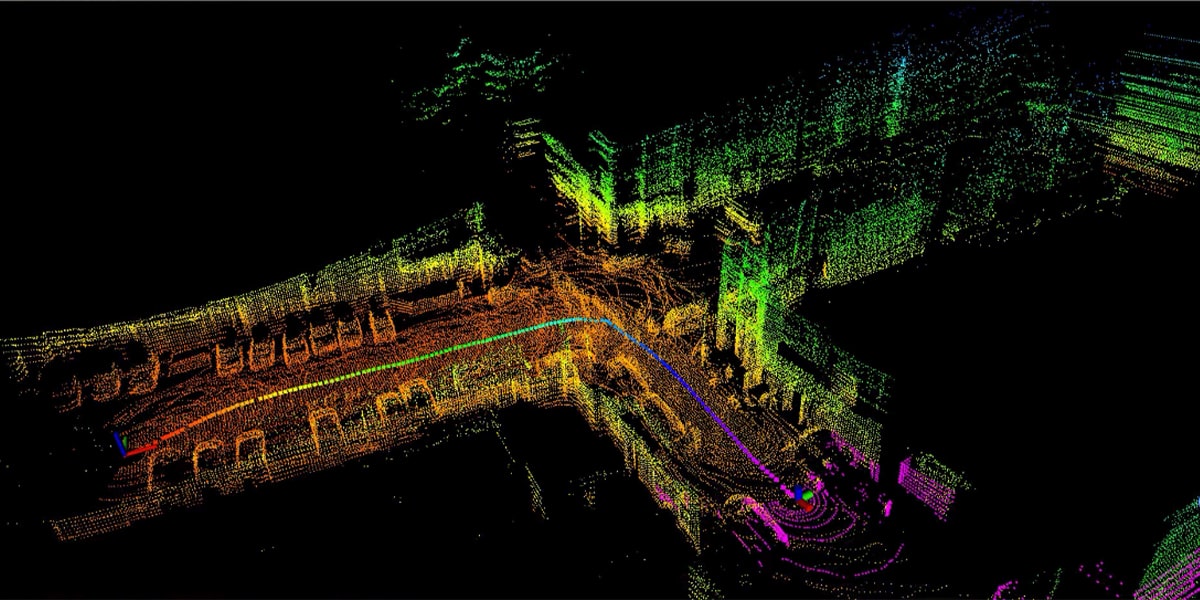

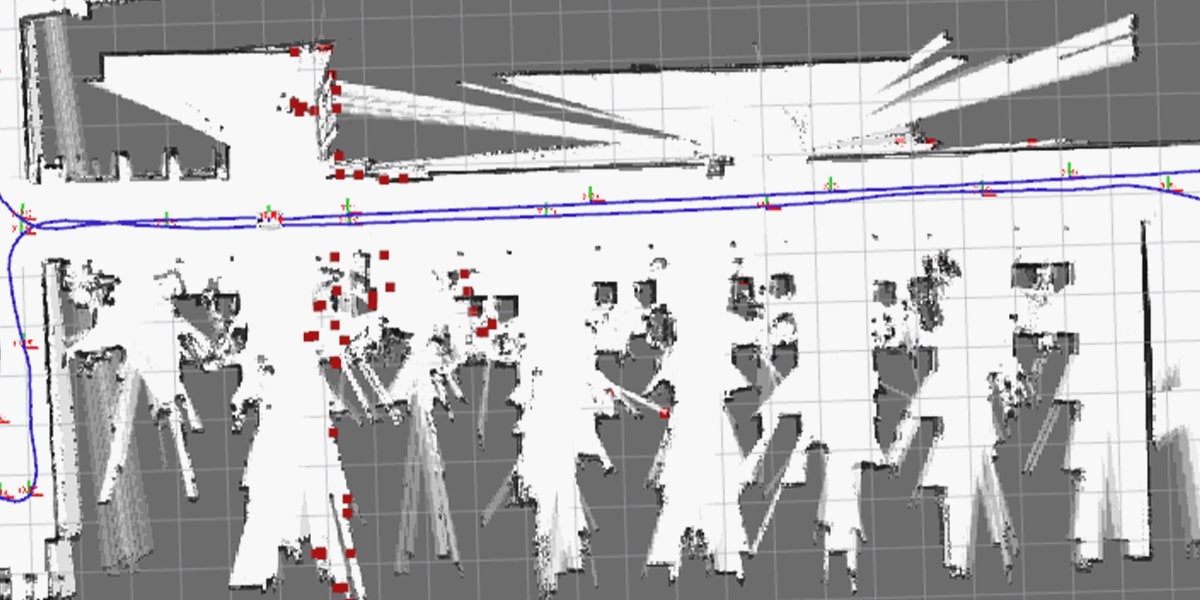

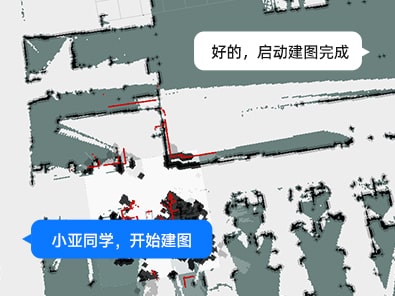

采用中长距离单线/长距离多线TOF激光雷达针对不同场景快速扫描构建二维/三维地图。

标配六麦阵列模块,结合科大讯飞语音识别功能,提供声源定位、召唤、语音交互等机器人应用。

标配IMU惯导模块,它包含三轴陀螺仪、三轴加速度计、三轴磁力计和气压计,为客户提供高精度、高动态、实时补偿的三轴姿态角度,可以实时提供高达 200Hz 更新率的数据。

触摸显示屏带金属外壳,并提供全面的防摔、防刮蹭保护。背部隐藏式走线设计。支持调节屏幕俯仰角度。

运用3D建图算法将视觉与雷达融合,实现了机器人三维视觉建图和导航避障,支持全局重定位,自主定位。

集成hector建图算法,可实现即时定位与地图构建功能

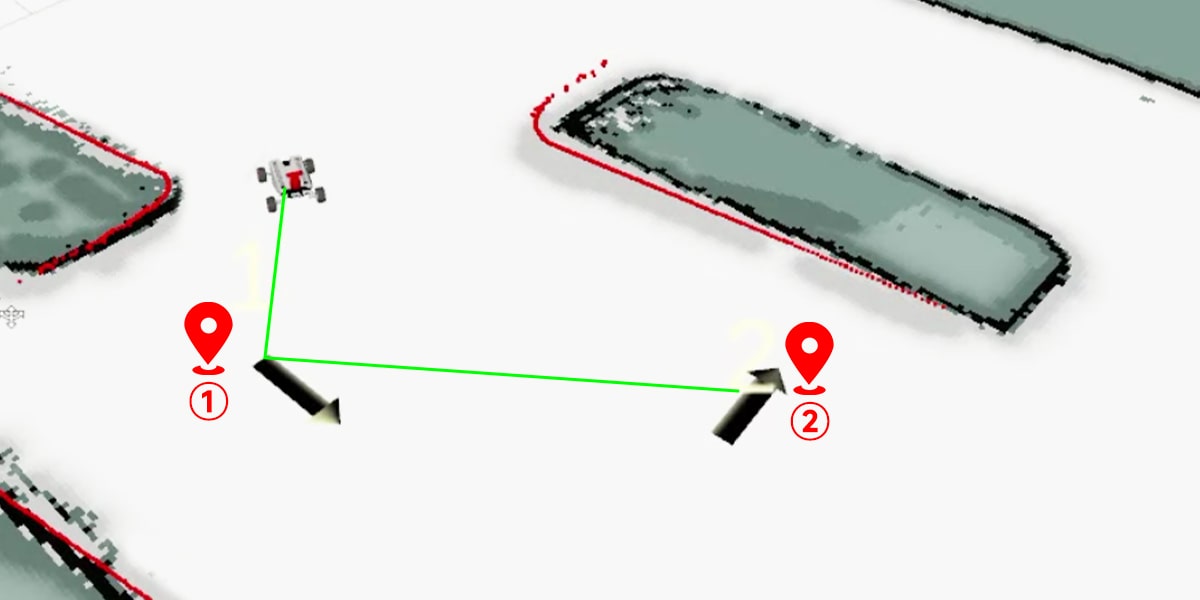

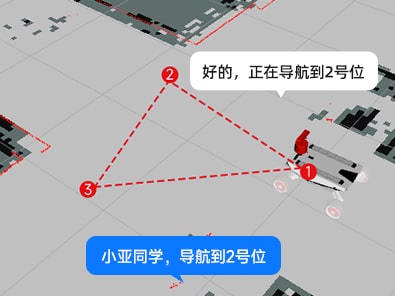

标记地图指定点后,解放双手,语音命令机器人自主导航去相应语音指定点。

激光雷达可实时检测周围环境,自主避开前方障碍物或实时跟随距离雷达最近目标进行运动。

距离雷达较近的目标将被锁定,车头始终朝向最近目标物。

通过ROS动态参数调整工具选择路径,小车按路径进行巡逻。

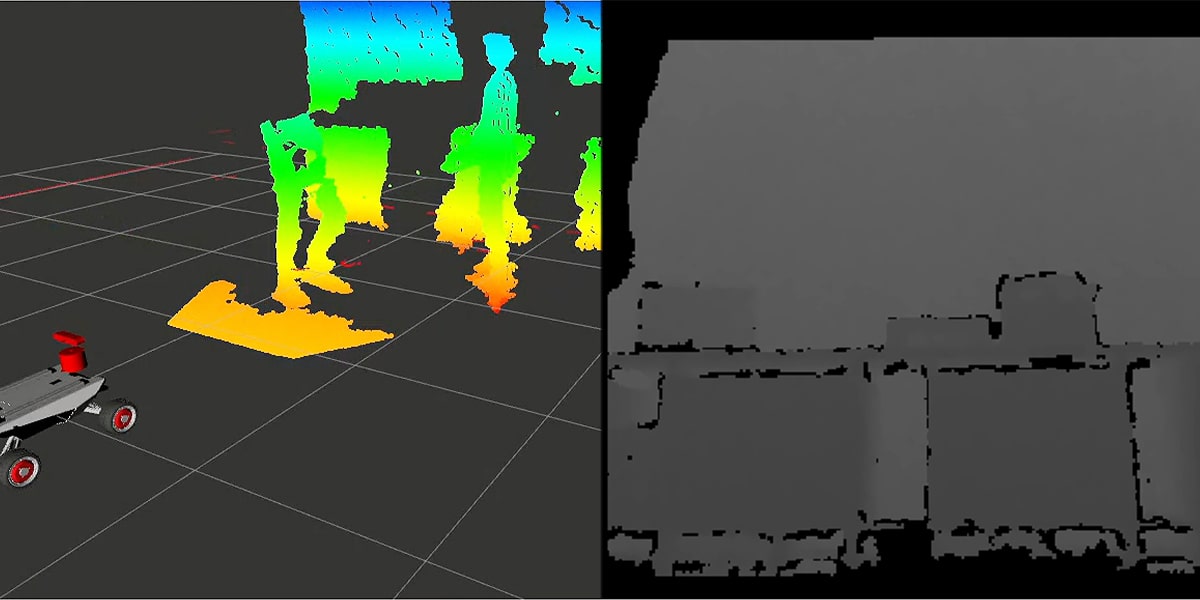

ORB-SLAM是一个支持单目、双目、RGB-D相机的开源SLAM框架,能够实时计算相机的位姿并同时对周围环境三维重建,在RGB-D模式下可以得到真实尺度信息。

通过相应的节点能够获取相机的深度图、彩色图、点云图。

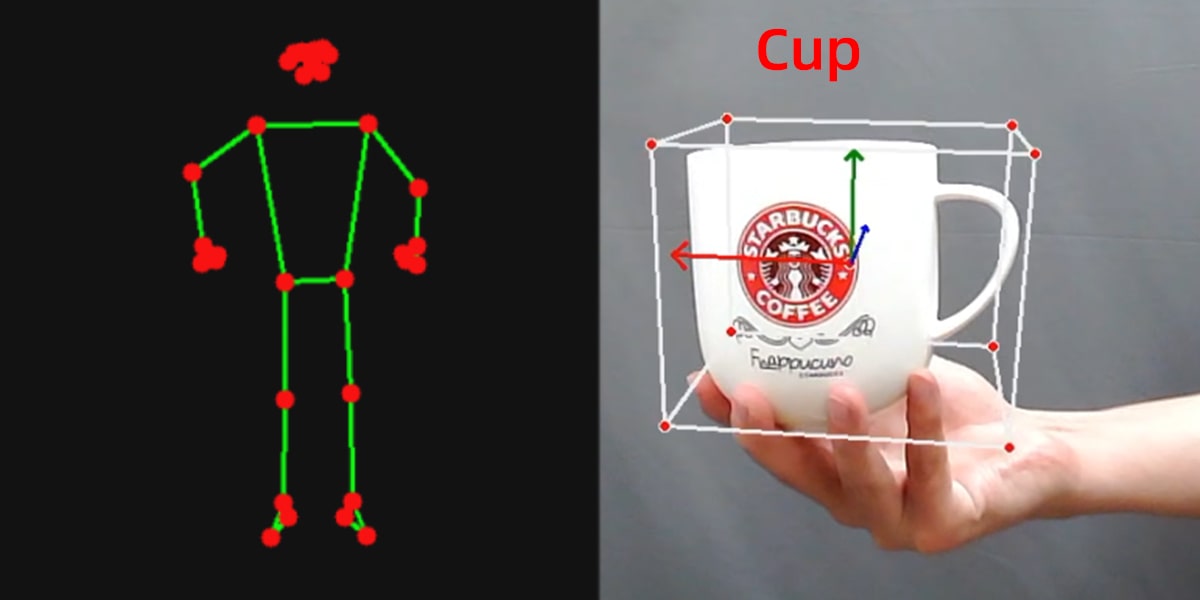

通过MediaPipe开发框架完成手部检测、姿态检测、整体检测、面部检测、三维检测识别等功能。

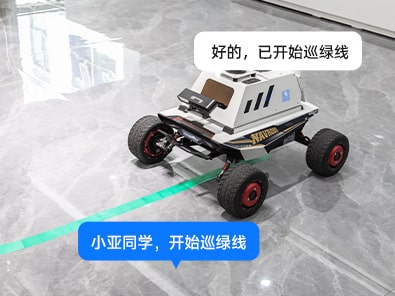

支持自定义颜色选择,机器人可自动识别颜色区域巡线行驶。

通过摄像头画面选取跟随目标,让机器人实时跟随目标移动。

通过深度相机实时检测周围环境识别行使路径上的障碍物,机器人会自动避开障碍物前进。

基于图像的相关KCF算法可选定图像中的任意物体,实时跟随目标。

通过画面选取颜色,让机器人实时跟踪目标颜色。

支持二维码标签动态跟踪检测,并实时获取二维码位姿坐标。

KNN算法原理/Tensorflow2.0/Pytorch yolov4-tiny/yolov5和TensorRT加速。

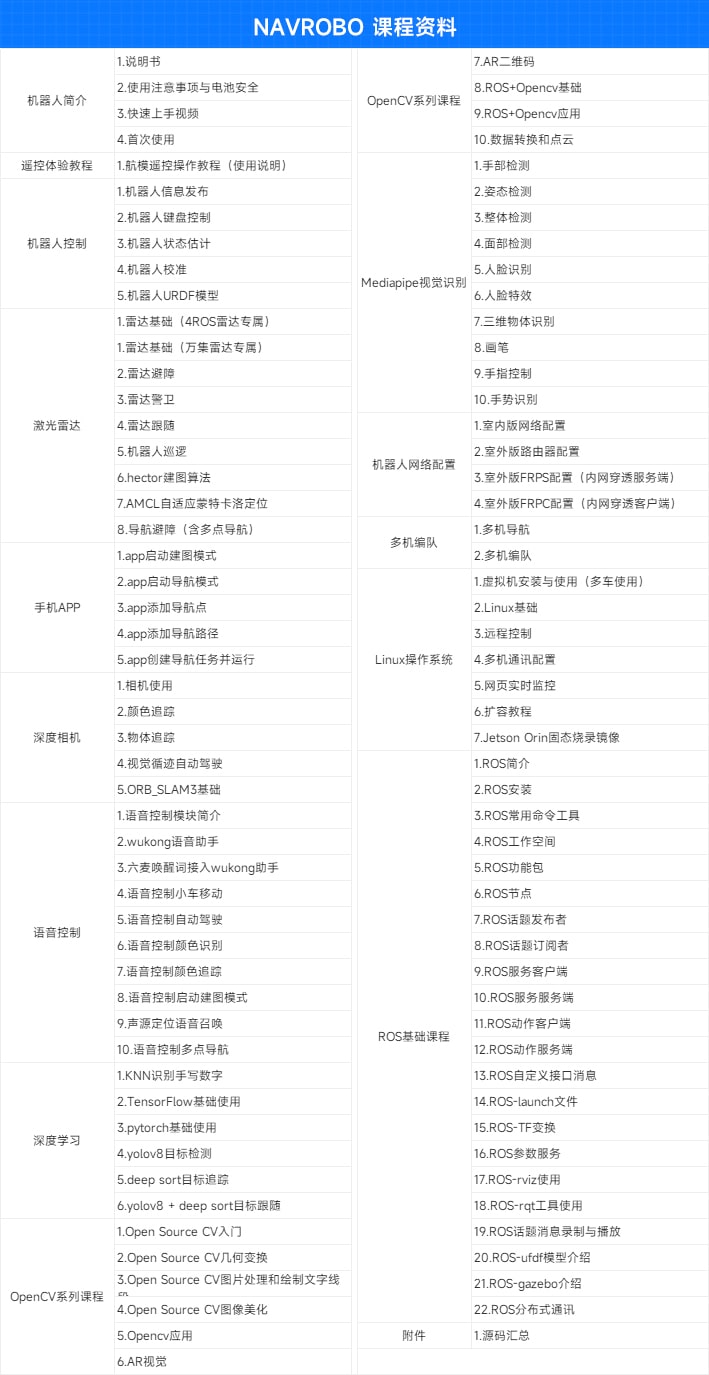

亚博智能配备精心研发的配套课程资料,提供基础理论知识与实操案例教程,内容由浅入深,方便用户快速上手学习。

提供源码解析,同时配备资深ROS工程师手把手带您玩转NAVROBO。