8b及以下

Deepseek本地部署教程

发布时间:2025-02-25

近期,DeepSeek在全球范围内引起了广泛关注,那么它是否能够部署到边缘计算设备上呢?

今天我们就来手把手教大家如何在树莓派等边缘计算设备上安装Deepseek-R1大语言模型的轻量版,也就是大家常说的蒸馏版。

* 亚博小课堂第53期

一、部署环境准备

1、开发板(4GB以上)

2、SD(TF)卡(建议16G以上,容量越大,可体验的模型更多)

本教程不仅适用于树莓派,同时适用于Jetson和RDK系列等平台,实际使用效果因设备性能和内存大小不同而有所差异。

以下为不同主控推荐使用的Deepseek模型参数:

| 主板 | 内存大小 | 推荐使用模型参数 |

|---|---|---|

树莓派 | 4GB | 1.5b |

8GB | ||

16GB | 14b 及以下 | |

Jetson Nano B01 | 4GB | 1.5b |

Jetson Orin Nano Super | 4GB | 1.5b |

| 8GB | 8b及以下 | |

Jetson Orin NX Super | 8GB | 8b及以下 |

| 16GB | 14b及以下 | |

| RDK X5 | 4GB | 1.5b |

| 8GB | 8b及以下 |

此外,需准备一张16GB以上的系统盘存储介质,考虑到单个模型文件动辄几个GB的大小,因此系统盘容量越大,能够下载的模型数量就越多,从而拓展了使用场景的可能性。

二、Ollama安装

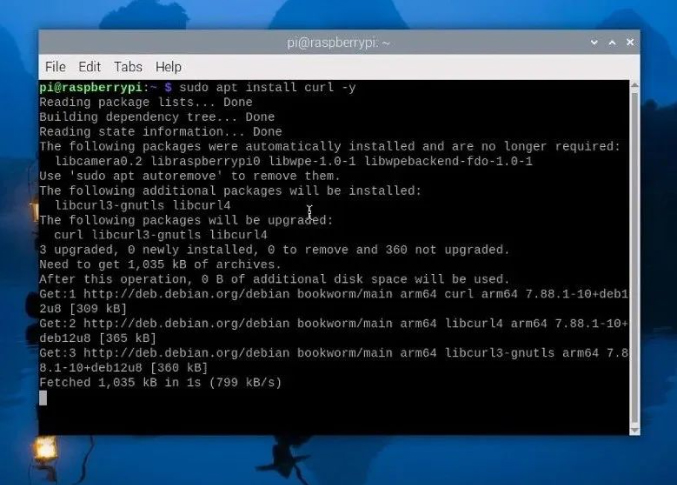

首先第一步开机,打开树莓派/Jetson或RDK终端终端,输入指令安装Ollama。

Ollama安装指令1:

sudo apt install curl -y

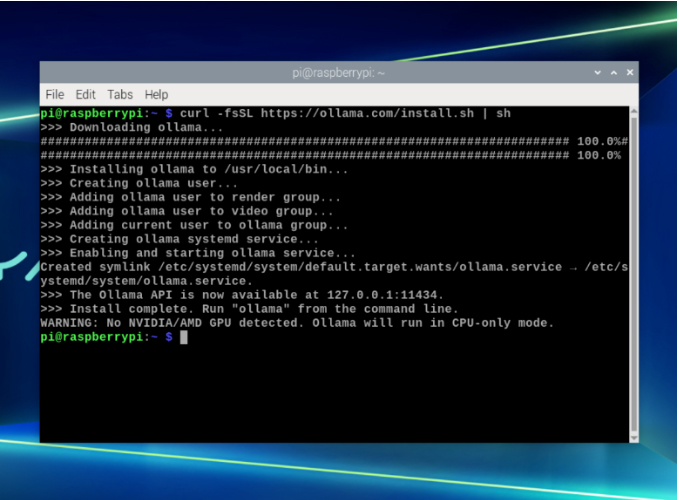

Ollama安装指令2:

curl -fsSL https://ollama.com/install.sh | sh

当出现这些内容就表示安装成功了,使用树莓派部署会有一个警告,内容是未检测到NVIDIA/AMD GPU,Ollama将以CPU模式运行,我们可以直接忽略这个警告并进行下一步。

使用Jetson等设备则没有这个警告,因此使用NVIDIA可以用上GPU加成,获得更流畅的使用体验。

三、什么是Ollama?

我们本次部署使用了一个强大的开源工具——Ollama。

GitHub:https://github.com/ollama/ollama

Ollama的设计旨在简化大语言模型的部署流程,免去了自行从零开始配置的繁琐,仅需几行命令就能轻松实现Deepseek R1模型的部署与运行。

四、运行Deepseek

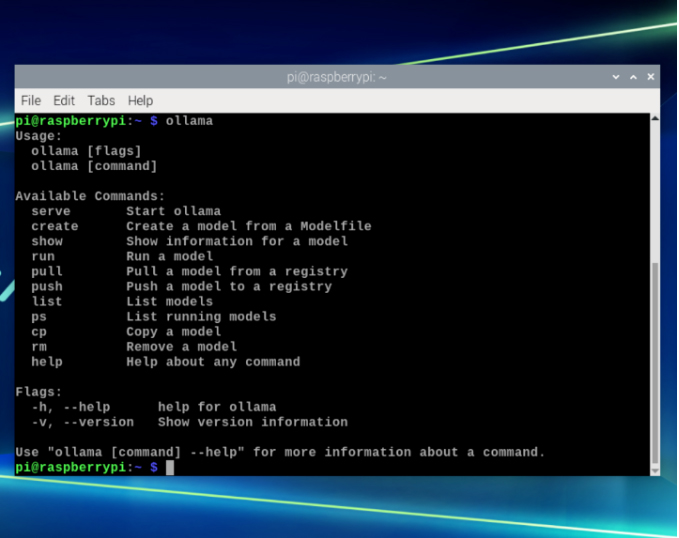

终端输入ollama可以看到提示:

ollama

这些都是模型操作相关指令,我们可以终端输入指令从注册表中拉取模型,这里以1.5b参数的模型为例运行Deepseek 1.5b模型指令:

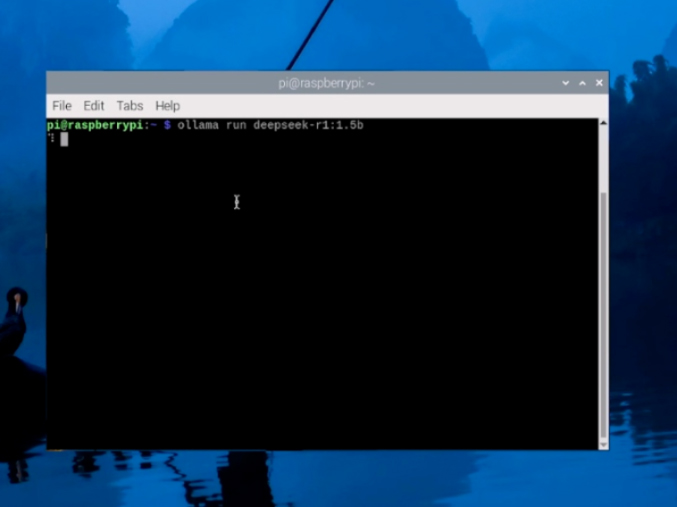

ollama run deepseek-r1:1.5b

下载完模型就可以进行文字交互了,从交互过程来看,系统响应流畅,基于Deepseek特有的深度思考推理,回答准确率令人满意。

接下来,如果大家想更换不同参数的模型进行体验,操作也非常简单。假设你有一个 8GB 运存的设备,可以尝试运行 8B 的Deepseek R1模型,只需在终端输入如下指令

运行Deepseek 8b模型指令:

ollama run deepseek-r1:8b

系统会自动从注册表中拉取该模型,下载完成后,便可立即展开与 8B 模型的文字交互,和 1.5b 模型相比,在处理复杂问题时能给出更细致、更具逻辑性的回答。

当然,如果你的设备内存达到了 16GB,不妨挑战一下 14B 的模型。在终端输入。

运行Deepseek 14b模型指令:

ollama run deepseek-r1:14b

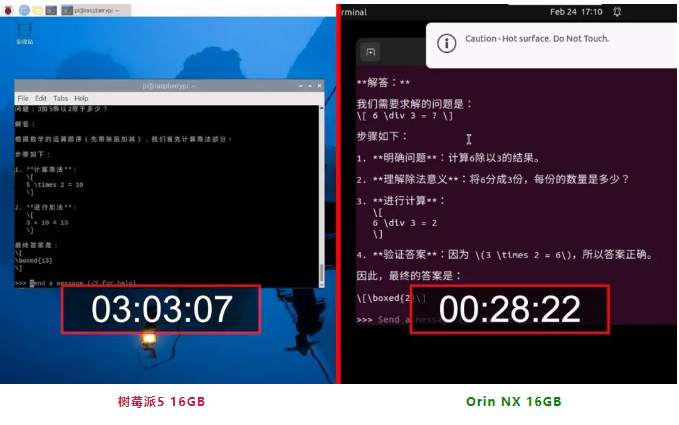

这个更大参数的模型对于各类专业领域的问题都能有更精准到位的解读。不过要注意的是,虽然14b模型功能强大,但对设备性能也有更高要求,实际测试在Jetson Orin NX 16GB上运行流畅,在树莓派5 16GB上运行非常缓慢。

五、总结

DeepSeek-R1大模型本地化部署,可以实现高效、低延迟的AI推理能力,降低了云端依赖,大幅提升响应速度与稳定性,为智能设备赋予更强大的自主决策能力。

大家可以根据自己设备的硬件性能,在树莓派、Jetson 系列主控、RDK 系列平台等边缘计算设备上选用合适的 deepseek - r1 蒸馏版大语言模型进行探索和体验,那么本期Deepseek部署教程就到这里啦。